(Gif: Google)

Takket være kunstig intelligens har rejser til udlandet aldrig været enklere.

Google Translate-appen giver brugerne mulighed for at oversætte tekst med det samme. I appen skal du bare rette kameraet mod den tekst, du vil oversætte, og du kan se det omdanne til dit ønskede sprog live lige foran dine øjne - ingen internetforbindelse eller mobiltelefondata er nødvendige. Denne praktiske funktion har været tilgængelig i nogen tid, men den havde kun været kompatibel med syv sprog. Nu takket være maskinindlæring har Google opgraderet appen til øjeblikkeligt at oversætte 27 sprog.

Så næste gang du er i Prag og ikke kan læse en menu, har vi ryggen, skrev Otavio Good, softwareingeniør hos Google, om virksomhedens forskning Blog .

Google brugte også bare AI til at skære deres talegenkendelsesfejl i halve.

Fra og med i dag kan følgende 20 sprog udover oversættelse mellem engelsk, fransk, tysk, italiensk, portugisisk, russisk og spansk også oversættes i realtid: bulgarsk, catalansk, kroatisk, tjekkisk, dansk, hollandsk, filippinsk, Finsk, ungarsk, indonesisk, litauisk, norsk, polsk, rumænsk, slovakisk, svensk, tyrkisk og ukrainsk. Og hvis du vælger at tage et billede i stedet for at se teksten oversættes live, understøttes i alt 37 sprog.

Så hvordan kunne Google øge antallet af tilgængelige sprog? De erhvervede først Word Lens, tidligere en augmented reality-oversættelsesapplikation, og brugte maskinindlæring og konvolutionsneurale netværk for at forbedre appens muligheder. Fremskridtene inden for billedgenkendelse var nøglen.

For fem år siden, hvis du gav en computer et billede af en kat eller en hund, havde den problemer med at fortælle, hvilken der var hvilken. Takket være sammenfaldende neurale netværk kan computere ikke kun fortælle forskellen mellem katte og hunde, de kan endda genkende forskellige racer af hunde, sagde Mr. Good. Ja, de er gode til mere end bare trippy kunst —Hvis du oversætter en fremmed menu eller underskriver med den nyeste version af Googles Translate-app, bruger du nu et dybt neuralt net.

Trin for trin

Først , Translate skal udrydde baggrundsstøv og finde teksten. Når den lokaliserer klatter med pixels i samme farve, bestemmer det, at det er bogstaver. Og når disse klatter er tæt på hinanden, forstår det, at det er en kontinuerlig linje, der skal læses.

Næste, appen skal genkende, hvad hvert enkelt bogstav er. Det er her, dyb læring kommer ind.

Vi bruger et sammenfaldende neuralt netværk, der træner det i bogstaver og ikke-bogstaver, så det kan lære, hvordan forskellige bogstaver ser ud, læser blogindlægget.

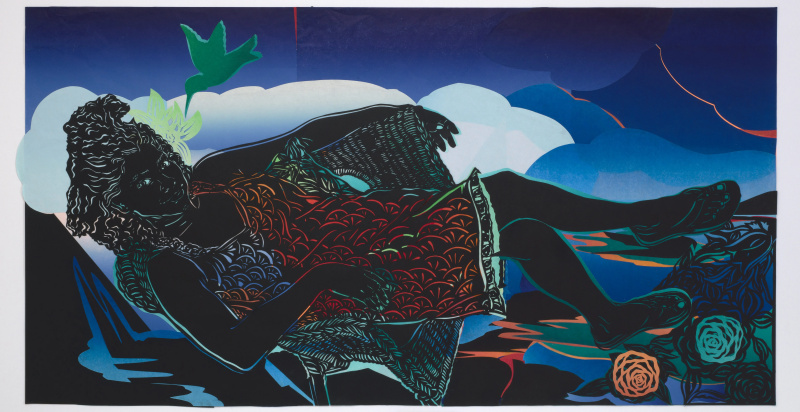

Forskerne var nødt til at træne softwaren ved hjælp af ikke kun rene bogstaver, men også beskidte. Bogstaver ude i den virkelige verden er skæmmet af refleksioner, snavs, pletter og al slags underlighed, skrev Mr. Good. Så vi byggede vores brevgenerator til at skabe alle mulige falske snavs for på en overbevisende måde at efterligne støj fra den virkelige verden - falske refleksioner, falske pletter, falsk underlighed rundt omkring.

Nogle af de beskidte breve, der blev brugt til træning. (Foto: Google)

Det tredje trin er at finde de anerkendte bogstaver i en ordbog for at få oversættelserne. Og for et ekstra forsøg på nøjagtighed er opslag i ordbøger omtrentlige, hvis en S læses forkert som en 5.

Endelig den oversatte tekst gengives oven på originalen i samme stil.

Vi kan gøre dette, fordi vi allerede har fundet og læst bogstaverne på billedet, så vi ved nøjagtigt, hvor de er. Vi kan se på farverne omkring bogstaverne og bruge det til at slette de originale bogstaver. Og så kan vi tegne oversættelsen ovenpå ved hjælp af den originale forgrundsfarve, lyder blogindlægget.

For at være så effektiv som muligt og tillade, at alle disse trin gennemføres i realtid uden en internet- eller dataforbindelse, udviklede Google-teamet et meget lille neuralt net med en øvre grænse for tætheden af information, det kan håndtere. Da de genererede deres egne træningsdata, var det vigtigt at medtage de rigtige data, men ikke noget ekstra, så det neurale netværk ikke bruger for meget af sin informationstæthed på uvigtige ting. Et eksempel ville være, hvordan det skal genkende et bogstav med en lille rotation, men ikke for meget.

I sidste ende er brugerne tilbage med 20 flere sprog, men den samme hurtige hastighed.

SE OGSÅ: Googles AI-team gav os nedturen på deres maskinlæringsforskning